Để website được index nhanh chóng, tối ưu SEO và đạt thứ hạng cao trên trang kết quả tìm kiếm SERP, bạn cần tạo file robots.txt cho WordPress.

Với sự phát triển mạnh mẽ của Internet, ngày càng nhiều cá nhân, doanh nghiệp bắt đầu sở hữu một website riêng để phục vụ cho các nhu cầu như chia sẻ thông tin, cung cấp sản phẩm, dịch vụ,...

Giữa một “rừng” website như vậy, làm sao để người dùng biết đến và truy cập website của bạn? Điều kiện thiết yếu là bạn phải đạt được hạng cao, tốt nhất là nằm trong khoảng 5 kết quả trả về đầu tiên khi tìm kiếm bằng các công cụ như Google.

Điều này đòi hỏi bạn phải tối ưu SEO cho website thật tốt. SEO là một quá trình tối ưu cần được thực hiện trong thời gian dài và có rất nhiều thủ thuật kèm theo trong đó. Chính vì vậy, bạn không cần quá lo lắng mà hãy bắt đầu từ những thủ thuật nhỏ nhất để cải thiện website của mình, ví dụ như tạo file robots.txt cho WordPress.

Sau khi đã tạo website bằng WordPress, bạn có thể tìm hiểu về những file robots.txt chuẩn SEO cho WordPress. Bài viết sau đây sẽ cung cấp cho bạn thông tin về:

- File robots.txt là gì? Tại sao website lại cần robots.txt WordPress?

- Cách tìm file robots.txt trên website

- Những mẫu file robots.txt chuẩn dành cho WordPress

- Cách tạo file robots.txt tùy chỉnh để tối ưu website

- Làm sao để ngăn công cụ tìm kiếm index các thông tin không cần thiết?

- Những công cụ nào hỗ trợ tạo file robots.txt cho WordPress?

Bây giờ thì bắt đầu ngay thôi!

Robots.txt WordPress là gì?

Đối với mỗi website, các công cụ tìm kiếm sẽ cho spider, crawler hay bot (được hiểu chung là những “con bọ”) tiến hành crawl và index nội dung trên trang web..

- Crawl: là thuật ngữ chỉ quá trình Google “ghé thăm” một trang web, sử dụng web bot để tiến hành thu thập thông tin và lần theo tất cả đường link có trên website đó.

- Index: là thuật ngữ chỉ quá trình Google xác nhận và lập các chỉ mục cho nội dung của một website. Hiểu đơn giản, những “con bọ” sẽ tiến hành lưu trữ, so sánh và đánh giá chất lượng nội dung của một website. Từ đó tác động đến kết quả hiển thị của website trên trang kết quả tìm kiếm SERP.

File robots.txt là một văn bản bao gồm tập hợp các quy tắc ngăn chặn/cho phép một trình thu thập dữ liệu nhất định truy cập vào đường dẫn tệp được chỉ định trong quy tắc đó.

Robots.txt WordPress tương tự như một bản quy định phạm vi hoạt động của bots trên website của bạn.

Tạo file robots.txt giúp search engine bots tương tác với site tốt hơn

Tại sao bạn cần tạo file robots.txt cho WordPress?

Có rất nhiều trường hợp bạn sẽ cần ngăn cản hoặc hạn chế search engine bots “quét” trang web của mình:

1. Các nội dung không có giá trị hoặc bị trùng lặp

Thực tế, trên website của bạn sẽ có rất nhiều thông tin khác được hiển thị, ví dụ như các tập tin thiết lập hệ thống, plugin WordPress,..

Những thông tin này đều không có giá trị với người dùng. Hơn nữa, một số tình huống phát sinh làm lặp nội dung của website, nếu các nội dung này vẫn được index thì sẽ làm loãng website, giảm chất lượng nội dung thật sự của trang web.

2. Các trang con để thiết lập và thử nghiệm website

Với trường hợp này, có thể khi bạn tự tạo website mới bằng WordPress, bạn vẫn chưa hoàn thiện quá trình thiết kế và thiết lập website, nói chung là chưa sẵn sàng để ra mắt người dùng thì bạn cần có biện pháp để ngăn cản search engine bots “quét” và xác nhận website của mình.

Không chỉ vậy, một số website còn có nhiều trang con chỉ dùng để thử nghiệm tính năng và thiết kế website, nếu để người dùng truy cập vào những trang như thế sẽ ảnh hưởng đến chất lượng website và sự chuyên nghiệp của công ty bạn.

3. Mất nhiều thời gian khi website có lượng nội dung lớn

Mỗi search engine bots chỉ có khả năng “quét” giới hạn cho mỗi lần truy cập website. Khi trang web của bạn có lượng nội dung lớn, bots sẽ phải mất nhiều thời gian hơn để crawl và index vì nếu đã hoạt động đủ cho một lượt truy cập, những nội dung còn lại trên website phải chờ đến lần tiếp theo bots quay lại mới có thể được crawl và index.

Nếu website bạn còn có những tập tin, nội dung không cần thiết nhưng lại được index trước, không chỉ giảm chất lượng website mà còn tốn thời gian index của bots nhiều hơn.

4. Làm giảm tốc độ trang khi phải tiến hành index liên tục

Khi không có file robots.txt, bots vẫn sẽ quét toàn bộ nội dung trên website của bạn. Không chỉ hiển thị những nội dung mà bạn không muốn khách hàng nhìn thấy (như các nội dung kể trên), thì việc crawl và index liên tục có thể làm giảm tốc độ tải trang.

Tốc độ trang là một trong những yếu tố quan trọng nhất của website, tác động đến chất lượng và trải nghiệm người dùng khi họ truy cập trang website của bạn.Tốc độ tải chậm có thể dẫn đến giảm lượng truy cập và tỉ lệ thoát trang cũng cao hơn.

=> Chính vì những lý do này, bạn nên tạo file robots.txt cho WordPress để chỉ dẫn cho bots: “Bots quét bên này thôi, đừng quét bên kia!”.

Sở hữu file robots.txt chuẩn cho WordPress sẽ giúp quá trình crawl cũng như index website của bots trở nên nhanh chóng và hiệu quả hơn. Từ đó, cải thiện kết quả SEO cho trang web của bạn.

File robots.txt nằm ở đâu?

Thông thường, khi bạn tạo một website bằng WordPress, nó sẽ tự động tạo ra một file robots.txt đặt trong thư mục gốc của địa chỉ website. Thư mục gốc là folder public_html mà bạn đã cài WordPress vào khi tạo website bằng WordPress.

File robots.txt WordPress ảo được tạo tự động

Bạn có thể truy cập vào đường dẫn tương tự như: tenmiencuaban.com/robots.txt để xem file robots.txt này.

Tuy nhiên, file robots.txt này chỉ là file ảo, vẫn hoạt động trên website nhưng không thể tìm thấy trong thư mục gốc hay chỉnh sửa được. Do đó, bạn có thể tạo robots.txt tùy chỉnh cho WordPress để thay thế file ảo trong thư mục gốc.

Các chỉ lệnh cơ bản trong file robots.txt WordPress

Mỗi tập tin robots.txt WordPress sẽ bao gồm nhiều quy tắc khác nhau, mỗi quy tắc được thể hiện bằng 1 chỉ lệnh nằm trên 1 dòng.

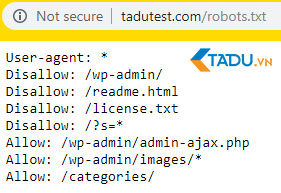

Ví dụ, khi truy cập tadutest.com/robots.txt, Tadu nhận được kết quả robots.txt WordPress như sau:

1. User-agent (Tác nhân người dùng)

- Đây là yếu tố bắt buộc, mỗi file sẽ có hoặc nhiều tác nhân và các quy tắc phải được phân rõ theo từng tác nhân người dùng.

- Tác nhân người dùng là một trình thu thập dữ liệu, hiểu đơn giản là tên của search engine bots, sẽ áp dụng nhóm quy tắc kèm theo được chỉ định trong file robots.txt

Ví dụ user-agent: googlebot, adbots-google, bingbot,...

- Ký tự * sẽ đại diện cho toàn bộ các trình thu thập dữ liệu (ngoại trừ các Adbots khác nhau).

- Bạn có thể tham khảo các trình thu thập dữ liệu của Google để chọn user chính xác khi tạo file robots.txt cho WordPress.

2. Disallow (Không cho phép)

- Mỗi tác nhân người dùng cần có ít nhất 1 quy tắc Disallow hoặc Allow.

- Disallow là quy tắc không cho phép tác nhân người dùng truy cập thu thập dữ liệu trong đường dẫn trang/thư mục được chỉ định.

- Đường dẫn trong lệnh Disallow cần phải có tên trang đầy đủ như được hiển thị trong trình duyệt hoặc kết thúc với / nếu đó là đường dẫn thư mục.

- Ký tự / sẽ đại diện cho phạm vi toàn bộ nội dung trên website mà tác nhân người dùng được chỉ định không cho phép thu thập dữ liệu.

- Ký tự * sẽ đại diện cho một tiền tố, hậu tố hoặc toàn bộ chuỗi đường dẫn.

3. Allow (Cho phép)

- Mỗi user-agent cần có ít nhất 1 quy tắc Allow hoặc Disallow.

- Allow là quy tắc cho phép tác nhân người dùng truy cập thu thập dữ liệu trong đường dẫn trang/thư mục được chỉ định.

- Lệnh Allow thường được dùng để ghi đè lên Disallow để thu thập thông tin từ một phần thư mục con hoặc trang con trong thư mục không được cho phép.

- Đường dẫn trong lệnh Allow cần phải có tên trang đầy đủ như trình duyệt hiển thị hoặc kết thúc bằng / nếu đó là đường dẫn thư mục.

- Ký tự / sẽ đại diện cho phạm vi toàn bộ nội dung trên website mà tác nhân người dùng được chỉ định cho phép thu thập dữ liệu.

- Ký tự * sẽ đại diện cho một tiền tố, hậu tố hoặc toàn bộ chuỗi đường dẫn.

Các lệnh Allow, Disallow trong robots.txt tạo ra quy tắc để bots hoạt động trên site

Ví dụ cú pháp chỉ lệnh cơ bản trong robots.txt WordPress

Khi tạo file robots.txt cho WordPress của website: https://tenmiencuaban.com/thu-muc-me/.

Để tạo quy tắc cho googlebot không được truy cập thư_mục_mẹ nhưng cho phép thu thập nội dung thư_mục_con nằm trong thư_mục_mẹ, bạn có thể kết hợp các chỉ lệnh Tadu vừa giới thiệu phía trên.

User-agent: googlebot

Disallow: /thu-muc-me/

Allow: /thu-muc-me/thu-muc-con/

Ví dụ thực tế

Khi truy cập file robots.txt chuẩn cho WordPress theo đường dẫn: https://tadutest.com/robots.txt, kết quả nhận được là:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php/

Các quy tắc này được áp dụng cho toàn bộ các trình thu thập dữ liệu theo quy ước ở phần User-agent. File robots.txt đã chỉ định các tác nhân người dùng:

- Không cho phép truy cập vào trang quản trị WordPress của website (theo đường dẫn https://tadutest.com/wp-admin/)

- Cho phép “quét” /admin-ajax/ nằm trong trang quản trị /wp-admin/ để hỗ trợ một số plugin hoạt động.

4. Noindex (Không đánh chỉ mục)

- Thông thường, một trang web khi đã được disallow thì vẫn có thể bị Google lập chỉ mục.

- Một số trường hợp trang không nên lập chỉ mục: trang có nội dung trùng lặp để thử nghiệm hoặc các landing page, trang cảm ơn chỉ dành cho một số đối tượng cụ thể,..

- Bạn có thể ngăn trình thu thập dữ liệu lập chỉ mục cho trang/thư mục nào đó với lệnh Noindex.

- Đường dẫn trong lệnh Noindex cần phải có tên trang giống như địa chỉ hiển thị trên trình duyệt. Trong trường hợp đó là thư mục thì cần kết thúc bằng /.

5. Sitemap (Sơ đồ trang web)

- Đây là quy tắc không bắt buộc, bạn có thể tùy chọn có hoặc không có sơ đồ trang web cho mỗi file robots.txt WordPress.

- Sitemap là một cách giúp bots biết nên thu thập nội dung nào, chứ không phải là có thể/không thể thu thập một nội dung nào đó.

- Thông thường, bots sẽ follow các link có trên website. Do vậy, bạn nên tạo sitemap cho WordPress để bots đánh giá được nội dung toàn trang, biết nội dung nào nên “quét” và từ đó cũng giúp kết quả SEO website được cải thiện tốt hơn.

Ví dụ cú pháp chỉ lệnh trong robots.txt WordPress

Giả sử bạn muốn tạo robots.txt cho WordPress để ngăn cản tất cả trình thu thập dữ liệu truy cập, lập chỉ mục cho trang cảm ơn theo đường dẫn:

https://tenmiencuaban.com/trang-cam-on/ và khai báo sơ đồ trang web.

Bạn có thể thêm vào file robots.txt các câu lệnh sau:

Mẫu file robots.txt chuẩn dành cho WordPress

Đây là mẫu file robots.txt chuẩn SEO dành cho WordPress dành cho các hosting khác nhau. Tuy nhiên, bạn có thể sử dụng trực tiếp hoặc tùy chỉnh để thêm các quy tắc cần thiết và phù hợp nhất với website của mình.

Cách tạo file robots.txt cho WordPress

1. Tạo file robots.txt cho WordPress bằng Notepad

Notepad là một trình soạn thảo văn bản đơn giản của Microsoft, thường được dùng để viết code phục vụ cho Pascal, C+, ngôn ngữ lập trình HTML,...

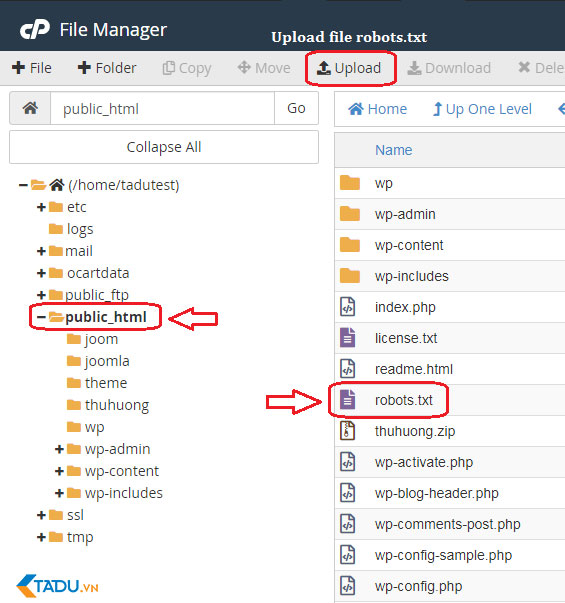

Bạn có thể upload robots.txt lên thư mục gốc bằng Cpanel hoặc FTP

Yêu cầu file robots.txt cho WordPress phải là tệp văn bản ASCII hoặc UTF-8, được lưu đúng tên “robots.txt” trong thư mục gốc của website. Mỗi file chứa nhiều quy tắc và mỗi quy tắc được trình bày trên một dòng.

Bạn có thể tạo một file notepad mới, lưu tên là robots.txt và tiến hành thêm các quy tắc vào như hướng dẫn phía trên.

Sau đó, upload file robots.txt cho WordPress lên thư mục public_html là hoàn tất.

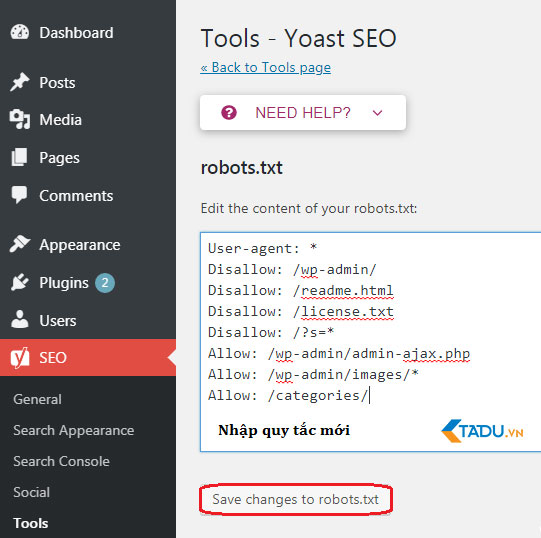

2. Tạo file robots.txt cho WordPress bằng plugin Yoast SEO

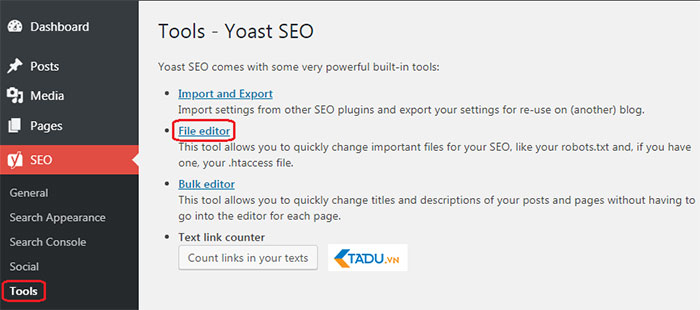

Plugin Yoast SEO là một trong những plugin được đánh giá tốt nhất để hỗ trợ bạn tối ưu SEO website về mặt nội dung. Tuy nhiên, Yoast SEO còn có thể xem là một robots.txt WordPress plugin giúp bạn tạo robots.txt cho WordPress nữa.

- Đầu tiên, bạn truy cập Dashboard qua đường dẫn: http://tenmiencuaban.com/wp-admin/

- Trong Dashboard > Chọn SEO > Chọn Tools hoặc Dashboard > Chọn Tools > Chọn Yoast SEO (đối với WordPress phiên bản/giao diện khác).

- Trong trang quản trị Yoast SEO > Chọn File Editor

Sử dụng Yoast SEO như một robots.txt WordPress plugin

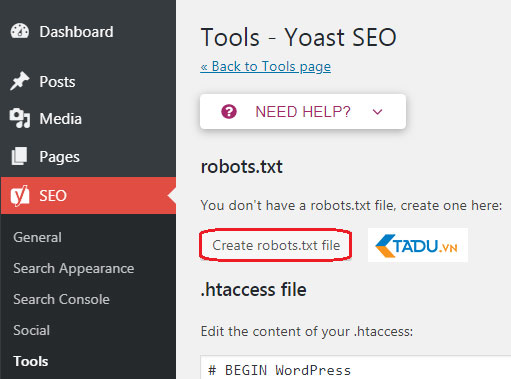

- Chọn Create new để tạo file robots.txt cho WordPress hoặc chỉnh sửa tập tin có sẵn

Tạo tập tin robots.txt tùy chỉnh bằng Yoast SEO

- Chọn Save changes to robots.txt để xác nhận file robots.txt tùy chỉnh hoàn tất.

Cập nhật và điều chỉnh các quy tắc trong file robots.txt bằng Yoast SEO dễ dàng

- Truy cập lại http://tenmiencuaban.com/robots.txt sẽ thấy hiển thị theo các quy tắc mới bạn vừa cài đặt.

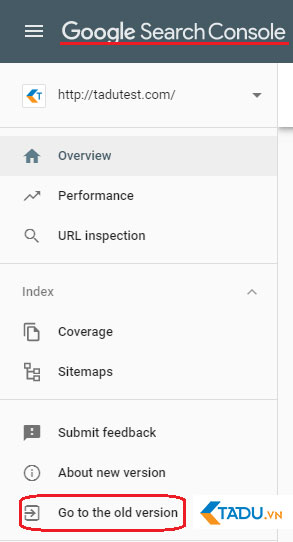

3. Kiểm tra file robots.txt trên Google Search Console

Bạn có thể đăng nhập Google Search Console và đăng ký property cho http://tenmiencuaban.com/ để bắt đầu.

- Chọn Go to old version để quay lại giao diện cũ dễ sử dụng hơn

Chuyển về giao diện Google Search Console cũ để tìm kiếm chức năng nhanh chóng hơn

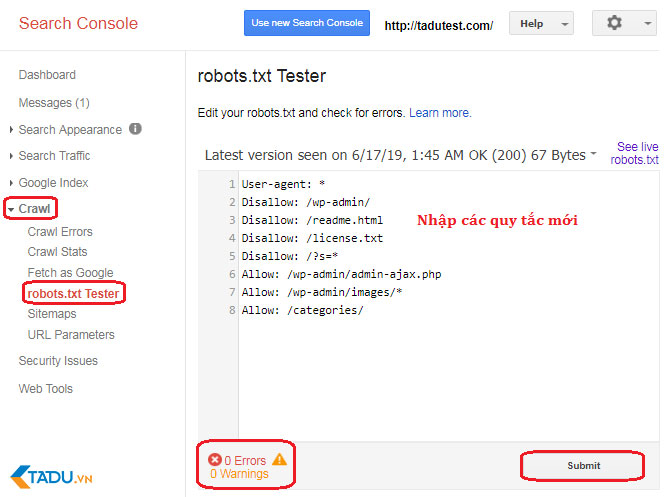

- Trong Crawl > Chọn robots.txt Tester > Nhập các quy tắc đã cài đặt > Nhấn Submit

- Kiểm tra kết quả số lượng Errors và Warnings > Tiến hành chỉnh sửa nếu có

Kiểm tra file robots.txt bằng Google Search Console

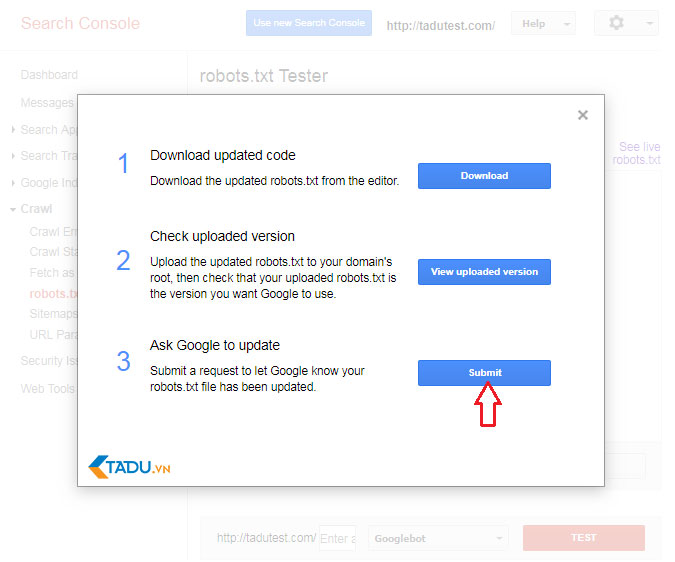

- Chọn Download updated code để tải về bản robots.txt mới và upload lại file mới lên thư mục gốc hoặc chọn Ask Google to Update để tự động cập nhật.

Tùy chỉnh và cập nhật file robots.txt cho WordPress

Qua bài viết này, bạn đã biết được tầm quan trọng của robots.txt và cách tạo file robots.txt cho WordPress. Sở hữu một file robots.txt chuẩn sẽ giúp website của bạn và search engine bots tương tác tốt hơn, từ đó thông tin của site cũng sẽ được cập nhật chính xác và tăng khả năng tiếp cận người dùng nhiều hơn nữa.

Hãy bắt tay vào tạo file robots.txt cho WordPress và cải thiện SEO website của bạn ngay thôi! Đừng quên để lại bình luận nếu bạn có bất kỳ thắc mắc nào cần được giải quyết nhé!